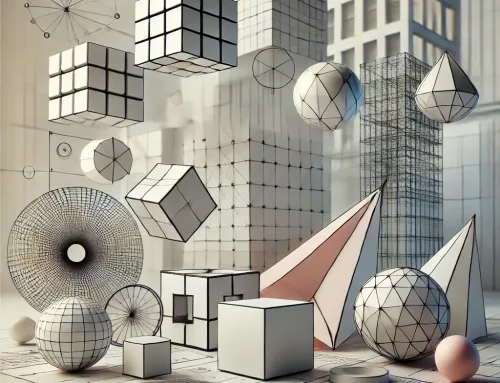

Wie Microsoft`s KI 3D-Objekte aus 2D-Bildern generiert.

Die KI Research Labs bei Facebook, Nvidia und Startups wie Threedy.ai haben sich an verschiedenen Stellen an der Herausforderung der Konvertierung von 2D-Objekten in 3D-Formen versucht.

Aber in einem neuen Preprint-Papier beschreibt ein Team von Microsoft Research ein Framework, von dem sie behaupten, es sei die erste „skalierbare“ Schulungstechnik für 3D-Modelle aus 2D-Daten. Sie sagen, dass es durchweg lernen kann, bessere Formen als existierende Modelle zu erzeugen, wenn es ausschließlich mit 2D-Bildern trainiert wird.

Dies könnte ein Segen für Videospielentwickler, eCommerce-Unternehmen und Animationsstudios sein, denen die Mittel oder das Fachwissen fehlen, um 3D-Formen von Grund auf zu erstellen.

Im Gegensatz zu früheren Arbeiten versuchten die Forscher, die Vorteile voll ausgestatteter industrieller Renderer zu nutzen – d.h. einer Software, die Bilder aus Anzeigedaten erzeugt. Zu diesem Zweck trainieren sie ein generatives Modell für 3D-Formen, so dass das Rendern der Formen Bilder erzeugt, die der Verteilung eines 2D-Datensatzes entsprechen. Das Generatormodell nimmt einen zufälligen Eingangsvektor (Werte, die die Merkmale des Datensatzes repräsentieren) auf und erzeugt eine kontinuierliche Voxeldarstellung (Werte auf einem Grid im 3D-Raum) des 3D-Objekts.

Anschließend werden die Voxel einem nicht differenzierbaren Rendering-Prozess zugeführt, der sie auf diskrete Werte schwellen lässt, bevor sie mit einem handelsüblichen Renderer (dem Pyrender, der auf OpenGL aufbaut) gerendert werden.

Ein neuartiger neuronaler Proxy-Renderer rendert direkt das kontinuierliche Voxel-Grid, das durch das generative 3D-Modell erzeugt wird. Wie die Forscher erläutern, ist er darauf trainiert, den Rendering-Output des serienmäßigen Renderers mit dem Output eines 3D-Meshs abzugleichen.

In Experimenten setzte das Team eine 3D Convolutional-GAN-Architektur für den Generator ein. (GANs sind zweiteilige KI-Modelle, die Generatoren umfassen, die synthetische Beispiele aus zufälligem Rauschen erzeugen, das mit Hilfe einer Verteilung abgetastet wird, die zusammen mit realen Beispielen aus einem Trainingsdatensatz dem Diskriminator zugeführt werden, der versucht, zwischen den beiden zu unterscheiden). Auf der Grundlage einer Reihe von synthetischen Datensätzen, die aus 3D-Modellen und einem realen Datensatz generiert wurden, synthetisierten sie Bilder aus verschiedenen Objektkategorien, die sie während des gesamten Trainingsprozesses aus verschiedenen Blickwinkeln darstellten.

Die Forscher sagen, dass ihr Ansatz die Beleuchtungs- und Shadinghinweise der Bilder nutzt, um aussagekräftigere Informationen pro Trainingsmuster zu extrahieren und bessere Ergebnisse in diesen Umgebungen zu erzielen. Darüber hinaus ist dieser in der Lage, realistische Proben zu erzeugen, wenn er auf Datensätze mit natürlichen Bildern trainiert wird.

„Unser Ansatz … erkennt erfolgreich die innere Struktur konkaver Objekte, indem dieser die Unterschiede in der Belichtung von Oberflächen nutzt“, schreiben die Koautoren der Arbeit, „und ermöglicht so die genaue Erfassung von Konkavitäten und Hohlräumen“.

Sie überlassen es der zukünftigen Arbeit, die Farb-, Material- und Lichtprognose in ihr System zu integrieren, um es auf die Arbeit mit „allgemeineren“ Datensätzen aus der realen Welt zu erweitern.

Vielen Dank für Ihren Besuch.